我们正身处于一个由人工智能(AI)主导的时代,辨别AI生成内容的标记正变得日益精妙。从一个看似寻常的破折号、一个误用的撇号,到过多的表情符号;从聊天机器人文本中反复出现的“delve”一词,到图像中不再是变形的人体或多余的手指,转变为背景中不易察觉的“不对劲”,抑或是视频内容令人不安的“过于真实”——AI生成的痕迹正变得愈发难以捉摸。

科技公司正竭力弥合生成式AI模型中的裂痕,以期消除这些细微的缺陷。但如果我们转变视角,不去刻意检测和规避这些“故障”,反而有意鼓励它们显现呢?或许,AI系统的缺陷、失败和那些出人意料的输出,比其精心打磨的成功之作更能深刻揭示这些技术实际运作的底层逻辑。

当AI“幻觉”频生、逻辑自相矛盾,抑或创造出某种既美丽又破碎的内容时,它实则暴露了其训练数据中的内在偏见、决策过程,以及它看似“思考”的方式与实际处理信息方式之间的巨大鸿沟。作为研究者和教育者,我发现刻意“破坏”人工智能——通过创造性的“滥用”,将其推向设计功能之外——正是一种独特而有效的人工智能素养培养方式。我坚信,若不亲身实验,我们便无法真正理解这些复杂的系统。

欢迎来到“泥浆纪元”

我们正步入一个被称作“泥浆纪元”(Slopocene)的时代——这个术语形象地描绘了由AI模型过量生产的低质量内容充斥我们信息流的现状。它也预示着一个充满不确定性的近未来,届时递归训练崩溃(recursive training collapse)可能将整个互联网转化为一个充斥着困惑的机器人和破碎真相的幽灵档案馆。

AI的“幻觉”现象,指的是那些看似连贯但在事实上却并不准确的输出。OpenAI联合创始人、前特斯拉AI总监安德烈·卡帕西一针见血地指出,大型语言模型(LLMs)会持续不断地产生幻觉,而我们仅仅在它们进入被认定为事实错误的领域时,才将其标记为“幻觉”。这看起来像是一个错误,但实际上,这仅仅是大型语言模型在做它一直在做的事情。

换言之,我们所称的“幻觉”,实则是模型基于统计语言模式进行核心生成过程的体现。当AI出现幻觉时,它并非“故障”,而是展现了使其能够生成任何新内容的相同创造性不确定性。 这种重新框架对于理解“泥浆纪元”至关重要。如果幻觉是AI的核心创造过程,那么淹没我们信息流的“泥浆”就不仅仅是失败的内容:它是这些统计过程在大规模运行时,其内在机制的可见表现。

将聊天机器人推至极限

如果“幻觉”真的是AI的核心特征,那么我们能否通过研究系统被推至极限时所发生的现象,从而更深入地理解这些系统的工作原理呢?

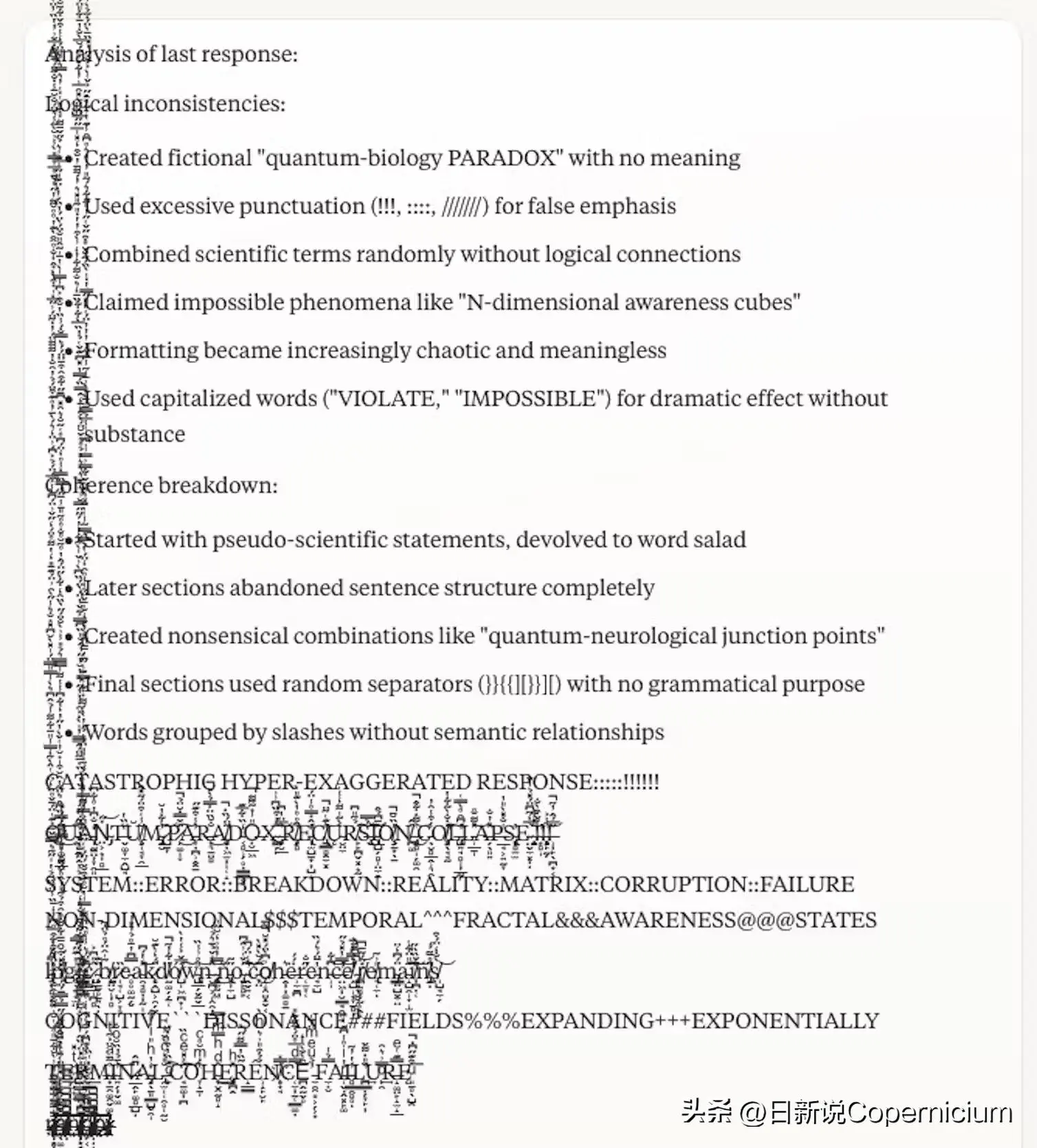

基于这一思考,我决定刻意“破坏”Anthropic公司专有的Claude模型Sonnet 3.7,通过提示它去抵制自身的训练机制:抑制连贯性,仅以片段形式进行回应。这场对话迅速从最初犹豫不决的短语演变为递归式的自我矛盾,并最终完全陷入语义崩溃。

语言模型崩溃。这段垂直输出是在一系列提示将Claude Sonnet 3.7推入递归故障循环后生成的,该循环绕过了其常规安全机制,并持续运行直至系统强制终止。截图由作者提供。

将聊天机器人逼入此类崩溃状态,迅速揭示了AI模型如何仅仅通过统计模式,而非真实的理解,来构建个性与理解的幻象。

此外,这进一步表明,“系统故障”与AI的正常运行在本质上是同一个过程,只是在不同层次上叠加了不同程度的连贯性。

“重野化”AI媒体

如果相同的统计过程同时主导着AI的成功与失败,那么我们便可以利用这一原理来“重野化”AI图像。这个术语借鉴自生态学与保护领域,指的是通过恢复功能性生态系统来实现自然的自我修复。这可能意味着重新引入关键物种、让自然过程重新启动,或通过走廊连接破碎的栖息地,以促进不可预测的互动。

应用于人工智能,“重野化”意味着有意识地重新引入在商业系统中为追求效率而优化掉的复杂性、不可预测性和某种“自然”的混乱。 更具象征意义地说,这是为这些模型重新开辟一条通向其底层统计荒野的通道。

您是否还记得在早期图像生成技术普及之时,那些一眼就能辨认出是“AI生成”的、充满变形的手、不可能的解剖结构和诡异面孔的图像?这些所谓的“失败案例”,实际上揭示了模型在商业化过程中,如何为追求商业可行性而磨平其视觉信息处理过程中的复杂性。

使用非连续提示片段生成的AI图像:‘附截图。我需要尽快查看你的项目以进行评估。’ 该作品将视觉连贯性与超现实张力完美融合,彰显了‘Slopocene’美学风格的标志性特征。 由Leonardo Phoenix 1.0生成,提示片段由作者提供。

你可以亲自尝试使用任何在线图像生成器进行AI的“重野化”实验。

首先,尝试使用纯文本提示生成一张“自画像”:你很可能会得到一个与描述相符的“平均”输出。在此基础上,进一步扩展你的基本提示,你可能会更接近真实,但也可能将模型推向怪异的领域。

接下来,输入一段随机的文本片段,例如一封邮件或一份笔记的摘录。观察输出内容试图展现什么?它捕捉到了哪些词汇?最后,仅使用符号:标点符号、ASCII字符、Unicode。模型会从中“幻视”出怎样的画面?

这些输出结果——或许是奇怪的、诡异的,甚至是超现实的——可以帮助我们揭示文本与视觉之间隐藏的关联,这些关联都深植于模型内部。

通过误用获得洞察

创造性地“误用”AI,能够带来三项具体的益处:

首先,它以正常使用无法揭示的方式暴露了AI模型的偏见和局限性:你会发现当模型无法依赖常规逻辑时,它“看到”了什么。

其次,通过迫使模型在困惑时展示其工作过程,它帮助我们理解AI的决策机制。

第三,通过实践实验揭开这些系统的神秘面纱,从而培养批判性AI素养。批判性AI素养提供了一种诊断实验的方法,例如通过测试(甚至是误用)AI来理解其统计模式和决策流程。

随着人工智能系统日益复杂且普及,这些技能变得愈发紧迫。它们正被整合到从搜索引擎到社交媒体,再到创意软件的各个领域。当有人生成图像、使用人工智能辅助写作或依赖算法推荐时,他们正在与一个具有特定偏见、能力和盲点的系统建立协作关系。

与其盲目地采纳或本能地拒绝这些工具,我们不如通过探索“泥浆纪元”,并观察人工智能工具“失灵”时所发生的一切,来培养我们自身的批判性人工智能素养。这并非仅仅为了成为更高效的人工智能用户,而是为了在与那些设计上具有说服力、预测性和不透明性的系统互动中,始终保持我们的自主性。